La politica ha scoperto TikTok da tempo, un po’ lo usa e un po’ lo teme: perché la app di video brevi è ormai il social network più in crescita e con un potere quasi ipnotico di catturare la nostra attenzione.

La Camera dei rappresentanti, negli Stati Uniti, ha deciso che TikTok è una minaccia per la sicurezza nazionale e ha approvato una legge per costringere la società che controlla TikTok, Bytedance, a vendere la app, o almeno le sue attività americane, che riguardano 170 milioni di utenti.

La legge deve ancora essere approvata dal Senato, ma ha già suscitato molte reazioni. E’ l’azione più ostile del governo degli Stati Uniti contro una piattaforma digitale, che non a caso è diretta contro l’unica piattaforma che non è a controllo americano.

Il Congresso sostiene che TikTok possa rispondere alle direttive del Partito comunista cinese e dunque essere usata contro l’interesse nazionale americano.

Ci sono molti segnali dell’influenza politica di Pechino, soprattutto sui video che toccano argomenti delicati per il regime comunista, come il massacro degli studenti in piazza Tienanmen nel 1989.

Nel 2016, però, i servizi segreti russi hanno usato Facebook – che nelle salde mani americane di Mark Zuckerberg – per lanciare campagne di comunicazione mirate per interferire nelle elezioni presidenziali e favorire Donald Trump.

Costringere Bytedance a vendere TikTok, insomma, potrebbe ridurre l’influenza diretta cinese, ma il problema principale rimarrebbe: le piattaforme digitali hanno troppo potere, non rendono conto del loro operato, e riescono a condizionare la nostra vita privata e pubblica in modi di cui spesso non siamo ben consapevoli.

Anzi, l’obbligo di cessione di TikTok potrebbe anche peggiorare la situazione: non ci sono molte aziende al mondo capaci di sborsare una cifra tra gli 80 e i 100 miliardi di dollari per acquisire il controllo della piattaforma, quasi tutti quelli con i soldi necessari sono grandi gruppi del digitale che già concentrano molto potere e molti dati degli utenti.

Un TikTok nelle mani di Google o di Facebook o di Microsoft non sarebbe meno inquietante di un TikTok cinese.

Perché il problema è il meccanismo di funzionamento di TikTok, molto più che la proprietà della maggioranza azionaria.

Cosa abbiamo scoperto

L’Autorità Antitrust italiana ha indagato su TikTok partendo da uno spunto all’apparenza minore, quello dei video che insegnano come procurarsi la cosiddetta «cicatrice francese», cioè a stringere così forte la pelle del viso fino a far emergere un doloroso segno rosso.

L’Antitrust ha concluso che la gestione di TikTok di quei video non tutela i minorenni, specie quelli più fragili, che potrebbero essere indotti all’autolesionismo o ad altri comportamenti problematici.

Nell’ambito di questa indagine, l’Antitrust ha ricostruito nel dettaglio come funziona TikTok. E così noi, forse per la prima volta, possiamo guardare dentro all’algoritmo.

Chi usa TikTok sa che l’opzione proposta dalla piattaforma per guardare video è quella del “Per te”, cioè video selezionati dall’algoritmo che potrebbero interessarci. Soltanto come alternativa ci sono i “seguiti”, cioè quelli prodotti da account che noi abbiamo espressamente scelto di seguire.

Quello che molti utenti non sanno è che TikTok lavora su due fronti: quello della profilazione e quello della raccomandazione. In base ai video che guardiamo riesce a capire chi siamo e a ricostruire informazioni che noi non abbiamo condiviso con la piattaforma.

Lo dice anche TikTok in modo esplicito nei documenti per gli utenti che nessuno legge:

«Deduciamo le vostre generalità (quali la fascia d’età e il genere) e gli interessi sulla base delle informazioni di cui disponiamo riguardo a voi. Utilizziamo tali informazioni dedotte, ad esempio, per mantenere la Piattaforma sicura, per moderare i contenuti e, ove consentito, per mostrare annunci personalizzati basati sugli interessi dell’utente».

Questo significa che TikTok è in grado di sapere cose su di noi che mai avremmo voluto comunicargli: può intuire se una donna è incinta, se ha appena partorito, se l’utente ha subito un lutto, se si è single o in coppia, se ha perso il lavoro o ha avuto un aumento e ha più soldi in tasca.

La app non si limita a tenere conto di quali video guardiamo, è molto più sofisticata. Usa algoritmi per stabilire correlazioni tra variabili per noi irrilevanti, e ricostruire così chi siamo e cosa vogliamo in modi più accurati di quello che potrebbe fare qualunque essere umano.

Per capire che una donna è incinta e può essere interessata a video sull’argomento parto, per esempio, non è necessario farle vedere video di bebé e misurare la sua attenzione, ma probabilmente basta incrociare la fascia di età, il variare delle sue abitudini di spostamenti, gli orari a cui interagisce con la app, il fatto che guardi meno video di cibo perché ha le nausee e così via.

Tutto questo TikTok riesce a farlo in frazioni di secondo ed è l’attività di profilazione. Aggregando poi tutte le informazioni che ha su di noi e su utenti simili a noi, TikTok sceglie i video da mostrare, e questa è l’attività di raccomandazione che è tanto più efficace quanto più siamo profilati.

Così TikTok riesce a farci vedere quello che noi vogliamo vedere, non quello che noi pensiamo di voler vedere. Infatti, tutti abbiamo l’impressione che i brevi video di TikTok brucino il nostro tempo senza lasciarci niente in cambio, perché non guardiamo video coerenti con i nostri interessi ma quelli che ci creano maggiore dipendenza.

Questo processo circolare di profilazione e raccomandazione consente a Tik Tok di vendere pubblicità molto mirata, in modi che perfino per le altre piattaforme digitali sono impensabili.

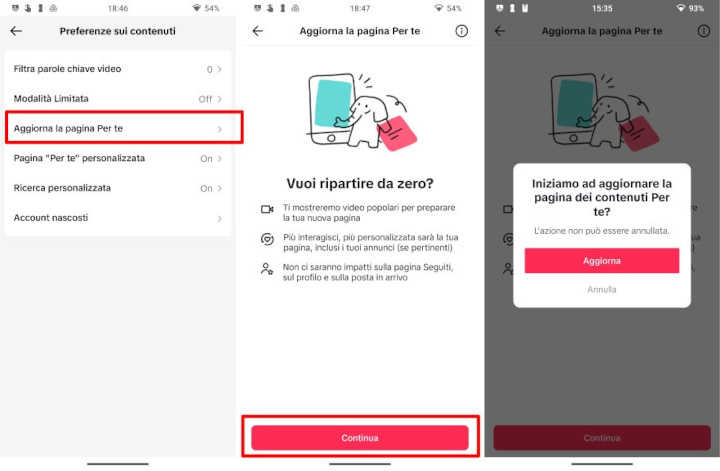

Noi utenti potremmo usare TikTok anche in altro modo, c’è la possibilità di azzerare la profilazione, oppure di chiedere di vedere i video più popolari nella nostra area geografica, invece che quelli selezionati dall’algoritmo nella sezione “per te”.

Ma quasi nessuno sceglie di sottrarsi all’ipnosi della raccomandazione, nel 2022 soltanto l’1 per cento degli utenti italiani lo ha fatto.

Milioni di utenti passivi passano ore a fissare brevi video in una programmazione che diventa sempre più personalizzata con l’utilizzo. E questo può generare disastri, come dimostra il caso della cicatrice francese.

La cicatrice francese

I video che in Italia promuovevano questa pratica autolesionistica erano relativamente pochi, 589, che hanno avuto però ben 5 milioni di visualizzazioni.

Il primo problema è che questi video hanno superato i filtri di TikTok che, in teoria, dovrebbe evitare di dare visibilità alle pratiche autolesionistiche, mentre invece li promuoveva nella sezione “per te”. Soltanto dopo le polemiche sulla stampa, TikTok ha introdotto qualche limite manuale.

TikTok dichiara che in Italia può contare su oltre 400 moderatori umani che revisionano i video segnalati dall’algoritmo o dagli utenti come critici. Ma il filtro algoritmico aveva lasciato passare i tutorial sulla cicatrice francese, e quindi nessun moderatore era intervenuto.

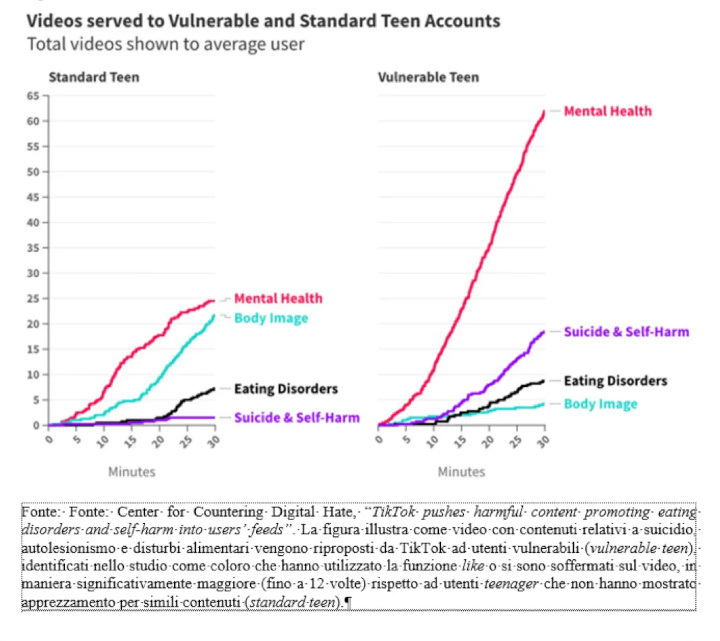

Il secondo problema è ben riassunto da un grafico pubblicato dall’Antitrust nella sua relazione sul caso TikTok: gli adolescenti vulnerabili, quelli con qualche problema manifesto o ancora latente, sono esposti a molti più video che riguardano problemi di salute mentale, suicidio o disturbi alimentari dell’adolescente medio.

Attenzione, ricordatevi cosa abbiamo detto del meccanismo di funzionamento di TikTok.

TikTok non è Google, dove i risultati si trovano se qualcuno li cerca. Un adolescente con disturbi alimentari potrebbe cercare su Google come smettere di mangiare, o come perdere peso molto rapidamente.

La funzione “cerca” è disponibile anche su TikTok, e in tanti la usano, ma la fruizione tipica della piattaforma è semplicemente lo swipe, un video dopo l’altro. Si lascia decidere alla piattaforma cosa guardare.

L’algoritmo è in grado di intuire che un adolescente che guarda certi video può nascondere un problema, un’inquietudine, e dunque gli mostra video che sicuramente gli interesseranno. Autolesionismo, disturbi alimentari, suicidio.

Anche se il ragazzo o la ragazza non ha dato forma al proprio disagio, e magari non lo ha ancora manifestato in alcun modo concreto, la piattaforma può spingerlo in una certa direzione bombardandolo di video sul tema, nei quali si vedono tanti altri ragazzi che fanno le stesse cose.

TikTok non può vendere pubblicità profilata diretta ai minorenni, ma ha tutto l’incentivo a tenerli il più possibile sulla piattaforma per far aumentare il valore delle inserzioni. Anche se si trovano a guardare video come quelli sulla cicatrice francese che insegnano come farsi male.

L’Antitrust italiana ha multato TikTok per 10 milioni di euro, che non sono pochi visto che nel 2022 il ramo italiano della piattaforma dichiarava ricavi per 20 milioni, e in più la piattaforma deve cambiare il modo di gestire i video sensibili e la protezione dei minori per rispondere ai rilievi dell’autorità.

Anche la Commissione europea ha iniziato ad applicare il nuovo Digital Service Act proprio da TikTok: Bruxelles contesta all’azienda che controlla la piattaforma, Byte Dance, di non tutelare abbastanza i minorenni e di non essere trasparente sulla pubblicità che ospita.

Non saranno però soltanto le multe o i controlli amministrativi ad arginare i danni potenziali di TikTok, conta anche la consapevolezza degli utenti.

La trappola collettiva

Uno studio recente di Leonardo Bursztyn e co-autori ha scoperto che in realtà anche i giovanissimi utenti di TikTok non sono così entusiasti della piattaforma come il loro uso compulsivo potrebbe far pensare.

Sono incastrati in una “trappola collettiva”, come la chiamano gli economisti, che è il lato oscuro del cosiddetto “effetto network”: poiché tutti i loro amici sono su TikTok, e lì si determinano mode, tendenze, da lì passano informazioni e intrattenimento, ridurre il tempo passato sulla app rischia di condannare un po’ all’esclusione sociale.

Un po’ come non avere la televisione in casa negli anni Ottanta, quando tutti guardavano la nascente tv commerciale e i nuovi programmi di intrattenimento.

In un esperimento Leonardo Bursztyn dell’Università di Chicago e i suoi co-autori hanno riscontrato che per disattivare TikTok e Instagram per due settimane gli studenti coinvolti nello studio chiedevano almeno 50 dollari per account.

Il risultato a sorpresa è però un altro: nell’esperimento, agli studenti veniva detto che se ci fossero stati abbastanza studenti disposti a lasciare i social per due settimane, allora tutti quelli dell’università avrebbero dovuto disattivare i loro account per un mese.

Di fronte alla prospettiva di stare quattro settimane senza TikTok, in media gli studenti si sono detti disposti a pagare ben 67 dollari per incentivare gli altri a smettere di usarlo, e così raggiungere la soglia critica per far scattare il blocco generalizzato.

In pratica, se tutti gli amici sono su TikTok, lasciare la app è un danno, ma se in qualche modo si riesce a convincere anche gli altri a staccarsene, allora disattivare l’account diventa un sollievo.

TikTok, ancor più di Instagram e Facebook, è un buco nero che ha inghiottito il nostro tempo, la nostra capacità di concentrazione; negli Stati Uniti l’ex vice presidente Mike Pence lo ha paragonato alla versione digitale del Fentanyl, un medicinale a base di oppiodi che genera dipendenza e che uccide ogni anno migliaia di americani.

Come il Fentanyl, anche TikTok e le altre piattaforme sono estremamente redditizie, soprattutto perché le aziende non sostengono il costo sociale dei danni che provocano. E come il Fentanyl, l’epidemia di dipendenza da TikTok non dipende soltanto da fattori chimici, da come reagiscono le nostre sinapsi, ma anche dalla società in cui queste scorciatoie per il benessere si inseriscono.

Non siamo condannati a rimanere nella «trappola collettiva» di TikTok, possiamo ancora salvarci. Il problema sono gli utenti più fragili, quelli che vengono manipolati e governati dall’algoritmo, e restano schiacciati nella morsa tra profilazione e raccomandazione.

- Dal Substack di Stefano Feltri, Appunti, 1 aprile 2024